Une fuite massive chez Google a dévoilé des détails sur les facteurs utilisés par le moteur de recherche dans le classement des pages web, provoquant un bouleversement auprès des professionnels du référencement.

Cette révélation, survenue après la mise à jour de l’algorithme de Google en mars 2024, pourrait avoir des implications majeures sur la manière dont les sites web doivent aborder le SEO, mais il faut avant tout bien comprendre ce qu’il s’est passé et se méfier des hypothèses non vérifiées.

La fuite de données : que s’est-il passé ?

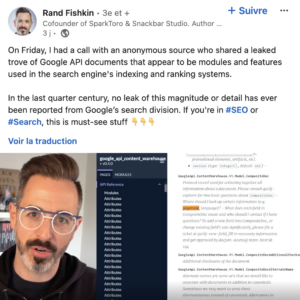

Le mardi 28 mai 2024, Rand Fishkin, fondateur de SparkToro et une figure incontournable du référencement, a publié un article annonçant une fuite de documents concernant Google et le référencement. Après avoir vérifié l’authenticité des documents auprès de diverses sources, y compris des employés et ex-employés de Google, il a décidé de les partager pour informer les professionnels du SEO en particulier.

Rand Fishkin a reçu environ 2 500 pages de documents internes de Google. Ils ont été rendus publics entre le 27 mars et le 7 mai 2024 sur GitHub, probablement par erreur, et proviennent principalement de la division Google Search et de la Content Warehouse API, où sont stockés le code et la documentation des APIs. Ce leak dévoile certains aspects jusqu’alors confidentiels du fonctionnement de l’algorithme de Google.

Cette fuite a des implications significatives pour les professionnels du SEO, car elle met en lumière des stratégies internes que Google utilise pour évaluer et classer les sites web, notamment à travers les données que l’entreprise collecte sur les pages web mais aussi sur les utilisateurs.

Les révélations qui peuvent impacter votre stratégie SEO

Les documents divulgués confirment certaines spéculations sur les critères de classement de Google, tout en révélant des pratiques internes que l’entreprise avait toujours nié employer notamment en termes de données collectées.

Même si les documents ne montrent pas le poids exacts des différents éléments dans l’algorithme de classement et que nous ne pouvons pas savoir lesquels sont réellement utilisés, ils révèlent tout de même des détails intéressants. Voici quelques exemples :

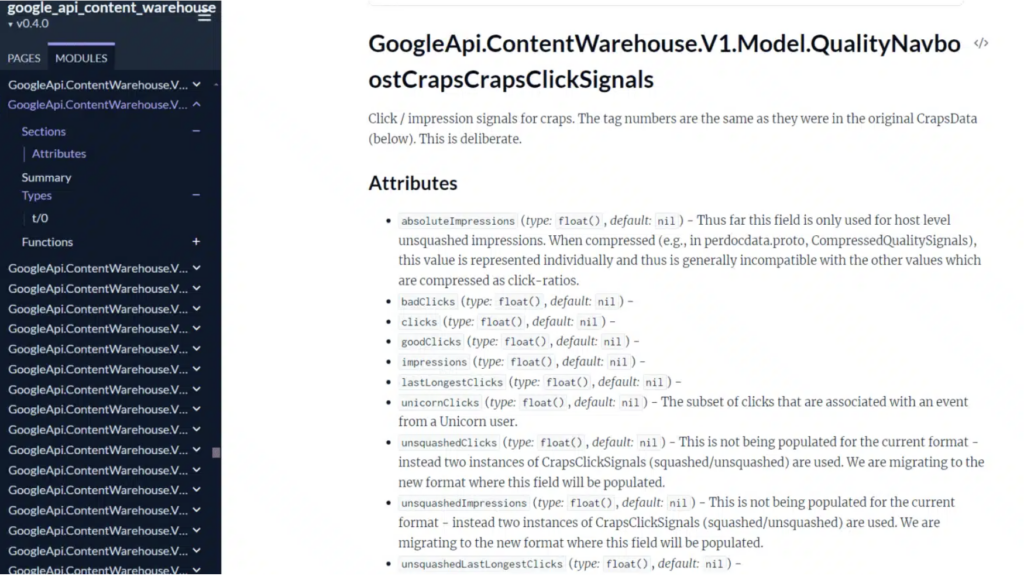

NavBoost utilise des données de clics et des données utilisateurs

NavBoost est un système développé par Google pour améliorer la qualité des résultats de recherche en utilisant les données de clics collectées initialement à partir de la barre d’outils PageRank, et ensuite, depuis le navigateur Chrome.

NavBoost recueille diverses données de clics

Même si Google l’avait toujours démenti, les documents suggèrent que l’entreprise dispose bien d’outils sophistiqués pour évaluer l’engagement des internautes à travers les clics.

Afin d’identifier les tendances de recherche, NavBoost collecte diverses données de clics :

- Le nombre de clics sur un résultat de recherche : un site qui a plus de clics qu’un autre est sûrement plus pertinent et donc plus populaire.

- La différence entre le nombre de clics longs et le nombre de clics courts : sur un clic long, l’utilisateur reste un certain temps sur la page et NavBoost en déduit que l’utilisateur est satisfait du résultat, alors que sur un clic court, il revient rapidement à la page de résultats.

- La différence entre le nombre de clics “écrasés” (“squashed” clicks) et le nombre de clics “non écrasés” : pour Google, les clics écrasés sont des clics de haute qualité et il utilise cela comme indicateur dans sa lutte contre les spams.

Google intègre des données issues de Chrome

C’est également sur ce point que la fuite vient contredire les déclarations publiques de Google. Selon Rand Fishkin, “Google utilise probablement le nombre de clics sur les pages dans les navigateurs Chrome pour déterminer les URL les plus populaires/importantes d’un site, qui entrent dans le calcul des URL à inclure dans la fonctionnalité sitelinks” et il pense que c’est d’ailleurs suite à la volonté d’analyser les flux de clics que l’entreprise aurait décidé de créer Google Chrome en 2008.

Dans son article, Mike King, expert SEO et fondateur de iPullRank, ajoute que parmi les modules liés aux scores de qualité des pages, il y a effectivement des attributs liés à Chrome, notamment les vues provenant de Chrome.

NavBoost segmente l’audience

NavBoost segmente géographiquement les données de clics en prenant en compte les pays, les états, ainsi que l’utilisation d’appareils mobiles par rapport aux ordinateurs.

Les clics peuvent pondérer les liens dans les SERP

Il semble que Google utilise trois niveaux pour évaluer les liens dans ses index : faible, moyen et élevé, en se basant sur les données de clics (nombre de clics et source des clics). Les liens fiables peuvent influencer le PageRank, tandis que les liens considérés comme non fiables sont simplement ignorés, sans nuire au classement du site.

Google établit des listes blanches sur certains sujets sensibles

Pour des sujets sensibles tels que les élections ou le Covid, Google applique des listes blanches qui vont favoriser ou défavoriser certaines pages afin d’éviter la propagande et la désinformation et donc de privilégier des sites fiables. Cela va également concerner des sites de voyage par exemple.

Avec une fuite de 2500 pages, les informations sont forcément nombreuses et cette liste est bien sûr non-exhaustive. De nombreux autres sujets sont évoqués :

- Utilisation de l’autorité de domaine

- Existence de la sandbox

- Pénalités pour les noms de domaine qui correspondent à une requête

- Importance de l’auteur des contenus

- …

Suite à ce leak, des experts du référencement vont certainement continuer de faire des découvertes et des hypothèses sur ce qui pourrait impacter votre stratégie SEO.

Ce qu’il faut retenir de cette fuite de données

Le 30 mai 2024, le porte-parole de Google David Thompson a confirmé l’authenticité des documents tout en mettant en garde contre “les hypothèses inexactes sur Search basées sur des informations hors contexte, obsolètes ou incomplètes”.

En effet, depuis que la fuite a eu lieu, de nombreux articles donnent des conseils pour améliorer votre SEO suite aux informations révélées. S’il peut être intéressant de se renseigner sur le sujet et de vous améliorer sur certains points, il ne faut pas oublier que ces documents nous apprennent qu’effectivement Google collecte ses informations, mais on ne sait pas réellement ce qu’il en fait et quel est leur impact sur le référencement.

Tout ce qui apparaît dans ces documents est soumis à interprétation. Rand Fishkin le rappelle dans son article : dans la documentation, il y a parfois des notes qui indiquent que certaines fonctionnalités ne doivent plus être utilisées, ce qui peut sous-entendre que celles qui ne sont pas marquées de telle manière sont encore utilisées, mais cela n’est qu’une supposition.

Les différents éléments évoqués dans la documentation permettent d’établir des suppositions sur l’algorithme de référencement, mais il n’est pas possible de savoir si tout est bien utilisé et dans quelle mesure. Il n’est pas non plus possible d’affirmer qu’il s’agit de la version la plus récente de la documentation, la dernière date évoquée étant au mois d’août 2023.

Conclusion

Les fuites récentes chez Google ont offert une vue rare des stratégies internes du géant pour maintenir la pertinence et la qualité de ses résultats de recherche, et soulignent l’importance pour les sites web de s’adapter constamment aux normes de l’algorithme de Google. Pour autant, les révélations suite à ce leak ne sont que partielles et il serait risqué de suivre toutes les recommandations et de changer complètement votre SEO.

Cette fuite nous apprend surtout que nous sommes loin de la transparence proclamée par Google et que le fonctionnement de son algorithme est même plutôt opaque. S’il peut être intéressant d’essayer de faire évoluer votre référencement en suivant certaines de ces révélations, il faut surtout retenir qu’il y a de nombreuses dynamiques cachées et que ce n’est pas ce leak qui va vous permettre de vous hisser facilement en première position sur Google.